昨天和同事开玩笑说,我又想到几个好玩又实用的topic,准备写下来;其实今天本来想蹭个热点写点别的,但是突然出了这么几个新闻,考虑再三,我还是写点技术文章吧!

今天的主题是讲一下Tensor

什么是Tensor? 不管做不做深度学习的各位,可能都听过Tensorflow,这是两个词的整合新词,前面的Tensor是核心,Tensor 直译就是张量,那么什么是张量?

张量是一个统称,细分下来有很多分支,举几个例子:

- 0阶张量:标量,就是我们日常所经常用到的常量,常数,一般记为0-DTensor

- 1阶张量:向量, venctor, 1-D Tensor

- 2阶张量:矩阵, martix, 2-D Tensor

- 3阶以后一般也就不会特意给起个名字了

阶/维度/服务器托管网dimension,可以近似认为是高维数组里的shape的个数

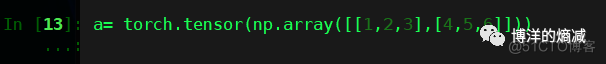

看一个例子:

我们先设定有一个Tensor为a

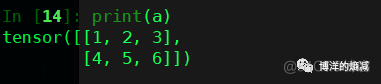

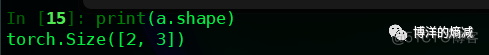

打印一下Tenso服务器托管网r a 的形状

可以看出Tensor a 是一个2行3列的矩阵,通过a.shape可以打印出a 的在每一个维度上的元素个数,而shape的个数就是Tensor的维度

这里介绍几种使用torch来创造Tensor的方法

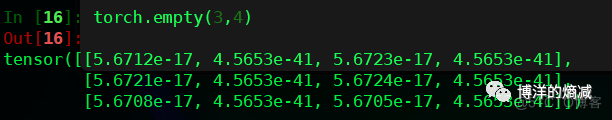

1-空Tensor(未初始化的Tensor)

当使用torch.empty来创建空Tensor的时候,torch会自动无意义的随机值来填充Tensor

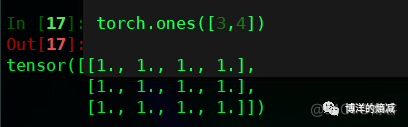

2- 全1Tensor

这个没什么可解释的

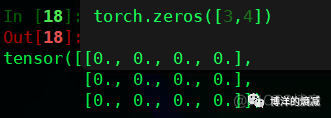

3- 全0Tensor

同上

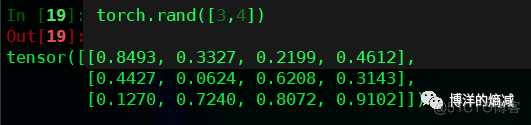

4-随机值Tensor

Tensor取值范围默认是0-1区间的数字

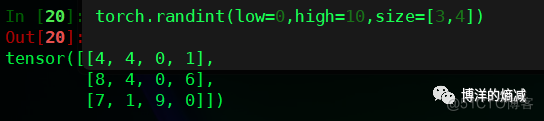

5- Randint整数Tensor

顾名思义,特点是可以设置整数区间

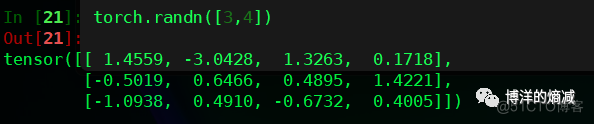

6- 高斯分布Tensor

就是个标准的正态分布,均值0,方差为1,尽可能模拟真实世界的随机data分配原则

以上这些Tensor的生成方法可以在做训练或者推理测试的时候用,作用是可以造临时测试数据,来验证训练或者推理的代码是否work

Tensor的属性

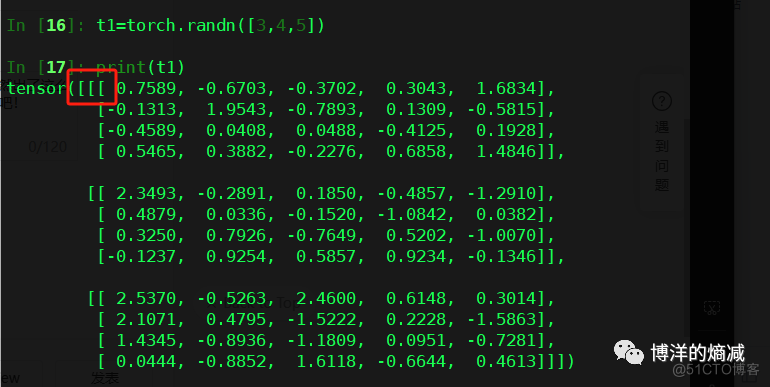

怎么一眼就知道操作的Tensor是几阶Tensor?

看中括号数量!

举个例子:

这就是个3阶Tensor

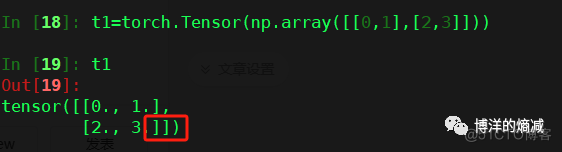

这就是2阶Tensor,矩阵

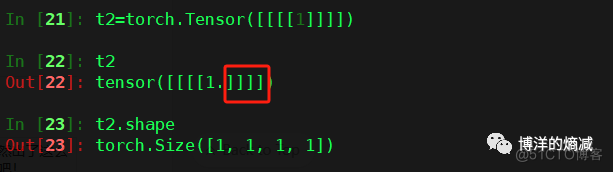

那么如果就给一个元素的多个中括号可以吗?

答案是可以的,如上图所示,4阶Tensor,在每个维度上就有一个元素

彩蛋:

写到这里,可能细心的读者已经发现了,在torch的api里,我怎么一会用tensor,一会用Tensor,那么这两个方法有什么区别呢?

大致有如下几个区别:

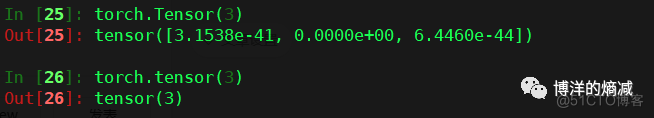

- Tensor相当于torch.empty 和torch.tensor的混合模式,而且它是有一个全局默认的数据类型的,FloatTensor就是浮点数,可以参考上图,在打印torch.Tensor创建的张量的时候,元素后面都会有一个”.”, 这个”.”就是浮点数的意思, 而使用torch.tensor创建的张量,是可以通过dtype来指定元素的数据类型,同时它也会自动根据输入的元素来匹配数据类型

- Tensor如果直接输入整数,默认是把这个数字当成元素个数来看(第一条我已经讲了,Tensor默认是有数据类型的,所以输入整数它不会认为是整形,而是当成元素的个数),而tensor则是当成具体元素的值(判断为整形)

- 最后一点也是本质区别,torch.Tensor 其实是个类,它有自己的构造函数,而torch.tensor本身是一个函数,本体是

torch.tensor(data, dtype=None, device=None, requires_grad=False)

写在最后,“情欲生于夏,因果了于秋”,今天确实不知道怎么形容,就先写这么多吧!

服务器托管,北京服务器托管,服务器租用 http://www.fwqtg.net

机房租用,北京机房租用,IDC机房托管, http://www.fwqtg.net

time(0)获取距离1970年1月1日的格林尼治(本初子午线所在地)时间差秒为单位与time_t t;time(&t)同理 由此我们可以制作一个简易的报时装置: 所需头文件stdio.h、stdlib.h、time.h 强迫症所需windows.h …