文章目录

-

- 1 进程启停管理

- 2 文件系统操作命令

-

- 2.1 HDFS文件系统基本信息

- 2.2 介绍

- 2.3 创建文件夹

- 2.4 查看指定文件夹下的内容

- 2.5 上传文件到HDFS

- 2.6 查看HDFS文件内容

- 2.7 下载HDFS文件

- 2.8 HDFS数据删除操作

- 3 HDFS客户端-jetbrians产品插件

-

- 3.1 Big Data Tools 安装

- 3.2 配置wind服务器托管网ows

- 3.3 配置Big Data Tools

- 结语

以下命令执行默认配置了hadoop的环境变量,且使用新命令。

1 进程启停管理

-

一键启停脚本

# 开启命令 start-dfs.sh # 停止命令 stop-dfs.sh -

独立进程启停

hdfs --daemon (start|status|stop) (namenode|secondarynamenode|datanode)

2 文件系统操作命令

2.1 HDFS文件系统基本信息

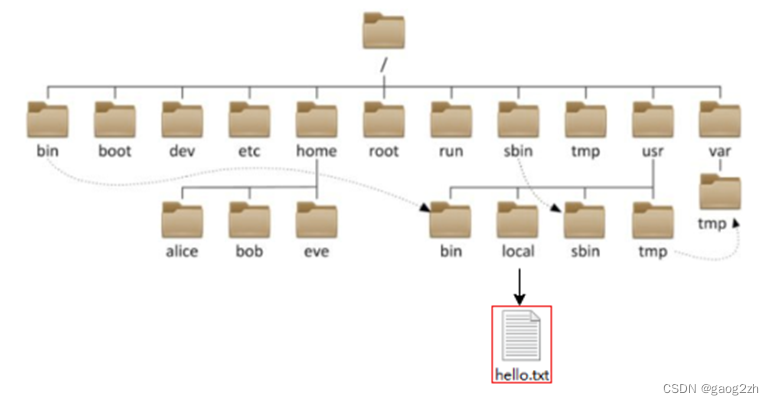

HDFS作为分布式存储的文件系统,有其对数据的路径表达式。如果熟悉Linux文件系统,可以对比学习。

- HDFS同Linux系统一样,均是以/作为根目录的组织形式

如何区分呢?

•Linux:file:/// 为linux的文件协议头

•HDFS:hdfs://为hdfs协议头

如上路径:

•Linux:file:///usr/local/hello.txt

•HDFS:hdfs://node1:8020/usr/local/hello.txt

协议头file:/// 或 hdfs://node1:8020/可以省略

•需要提供Linux路径的参数,会自动识别为file://

•需要提供HDFS路径的参数,会自动识别为hdfs://

除非你明确需要写或不写会有BUG,否则一般不用写协议头

2.2 介绍

关于HDFS文件系统的操作命令,Hadoop提供了2套命令体系

•hadoop命令(老版本用法),用法:hadoop fs [generic options]

•hdfs命令(新版本用法),用法:hdfs dfs [generic options]

两者在文件系统操作上,用法完全一致

用哪个都可以

某些特殊操作需要选择hadoop命令或hdfs命令

讲到的时候具体分析

下面以新版本用户hdfs命令为例介绍

2.3 创建文件夹

语法:

hdfs dfs -mkdir [-p] path> ...

- mkdir:创建文件夹

- -p:如果父目录不存在,创建

- path:待创建的目录

示例:

hdfs dfs -mkdir -p /gaogzhen/bigdata

2.4 查看指定文件夹下的内容

语法:

hadfs -ls [-h] [-R] [path> ...]

- -h:人性化显示文件size

- -R:递归查看指定目录及其子目录

示例:

hdfs dfs -ls -R /

[hadoop@node1 ~]$ hdfs dfs -ls -R /

drwxr-xr-x - hadoop supergroup 0 2023-08-30 20:44 /gaogzhen

drwxr-xr-x - hadoop supergroup 0 2023-08-30 20:46 /gaogzhen/bigdata

-rw-r--r-- 3 hadoop supergroup 20 2023-08-30 20:46 /gaogzhen/bigdata/words.txt

2.5 上传文件到HDFS

语法:

hdfs dfs -put [-f] [-p] src> ... dst>

- -f :覆盖目标文件(如果存在);

- -p:保留访问和修改权限,所有权和权限;

- src:本地文件系统

- dst:目的文件系统(HDFS)

示例:

hdfs dfs -put -f words.txt /gaogzhen/bigdata

2.6 查看HDFS文件内容

语法:

hdfs dfs -cat src> ...

- 读取指定文件全部内容,显示在标准输出控制台

同Linux一样,可以配置more less 使用。

示例:

hdfs dfs -cat /gaogzhen/bigdata/words.txt

node1

node2

node3

`

2.7 下载HDFS文件

hdfs dfs -get [-f] [-p] ...

-

下载文件到本地文件系统指定目录,localdst必须是目录

-

-f 覆盖目标文件(已存在下)

-

-p 保留访问和修改时间,所有权和权限。

2.8 HDFS数据删除操作

hdfs dfs -rm -r [-skipTrash] URI [URI ...]

-

删除指定路径的文件或文件夹

- -skipTrash 跳过回收站,直接删除

回收站功能默认关闭,如果要开启需要在core-site.xml内配置:

property>

name>fs.trash.intervalname>

value>1440value>

property>

property>

name>fs.trash.checkpoint.intervalname>

value>120value>

property>

无需重启集群,在哪个机器配置的,在哪个机器执行命令就生效。

回收站默认位置在:/user服务器托管网/用户名(hadoop)/.Trash

其他常用命令可以查看官网文档,这里不在一一介绍,属性Linux系统的话,这些命令都轻车熟路。

3 HDFS客户端-jetbrians产品插件

我们使用DataGrip来安装和配置插件。

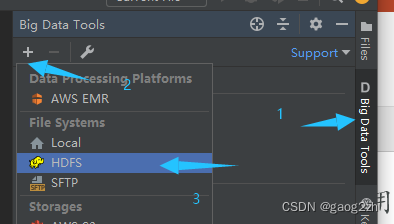

3.1 Big Data Tools 安装

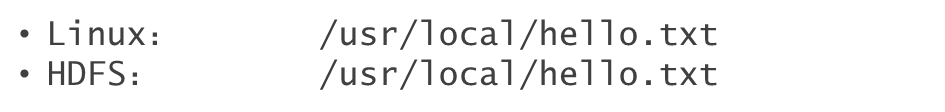

打开设置settings->plugins->搜索Big Data Tools->install,如下图所示:

安装之后,重启DataGrip。

3.2 配置windows

需要对Windows系统做一些基础设置,配合插件使用

-

解压Hadoop安装包到Windows系统,如解压到:E:gaogzhendevbigdatahadoophadoop-3.3.4

-

设置$HADOOP_HOME环境变量指向:E:gaogzhendevbigdatahadoophadoop-3.3.4

-

path中添加

$HADOOP_HOMEbin

下载

-

hadoop.dll(https://github.com/steveloughran/winutils/blob/master/hadoop-3.0.0/bin/hadoop.dll)

-

winutils.exe(https://github.com/steveloughran/winutils/blob/master/hadoop-3.0.0/bin/winutils.exe)

可以自行下载,或从课程资料中获取

- 将hadoop.dll和winutils.exe放入$HADOOP_HOME/bin中

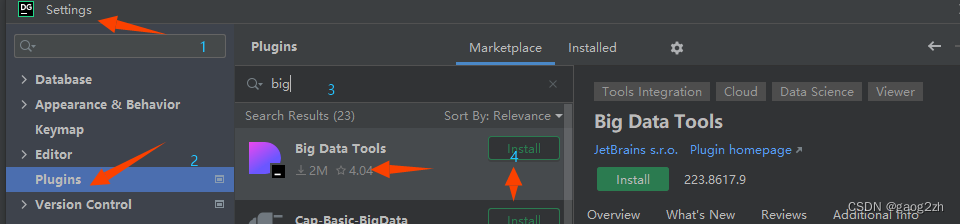

加压报错如下图所示:

这个是Linux系统的软连接,不影响目前的功能,直接关闭即可

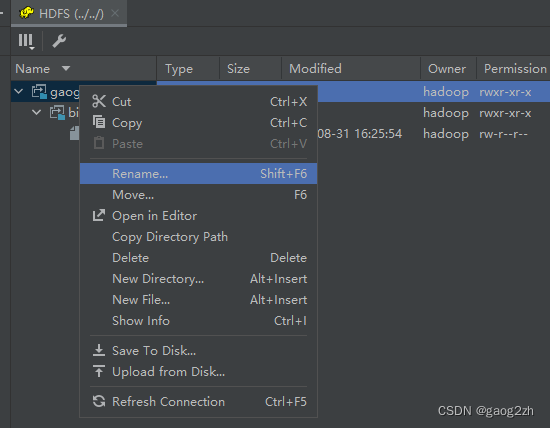

3.3 配置Big Data Tools

第一步:打开hdfs配置

第二步:配置hdfs

现在可以以图形化的形式对hdfs进行操作

HDFS客户端,以NFS 挂载客户端的形式自行查阅相关文档,这里不在演示。

结语

如果小伙伴什么问题或者指教,欢迎交流。

❓QQ:806797785

参考链接:

[1]大数据视频[CP/OL].2020-04-16.

服务器托管,北京服务器托管,服务器租用 http://www.fwqtg.net