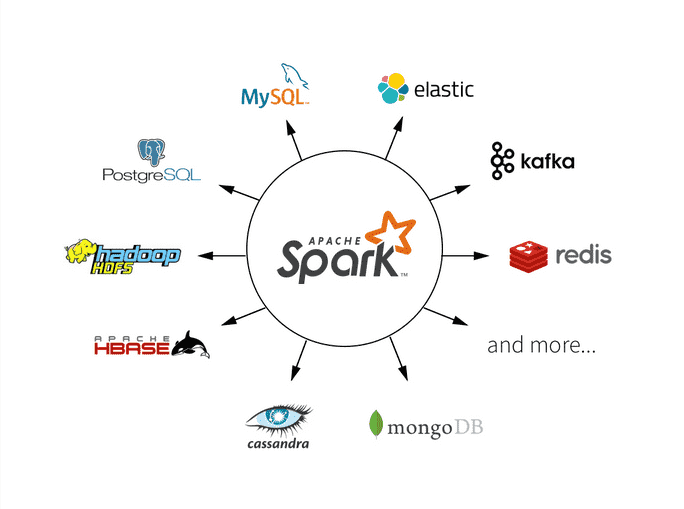

Apache Spark是一个强大的分布式计算框架,用于处理大规模数据。在Spark中,数据加载与保存是数据处理流程的关键步骤之一。本文将深入探讨Spark中数据加载与保存的基本概念和常见操作,包括加载不同数据源、保存数据到不同格式以及性能优化等方面的内容。

数据加载

在开始使用Spark进行数据分析和处理之前,首先需要加载数据。Spark支持多种数据源,可以根据您的需求选择合适的数据加载方法。以下是一些常见的数据加载方式以及示例代码:

1 从文本文件加载数据

加载文本文件是最常见的数据加载方式之一。可以使用textFile方法来加载文本文件,并将其转换为RDD(弹性分布式数据集)。

from pyspark import SparkContext

# 创建SparkContext

sc = SparkContext("local", "DataLoadingExample")

# 从文本文件加载数据

text_data = sc.textFile("data.txt")

# 显示数据

text_服务器托管网data.take(5)

2 从CSV文件加载数据

如果数据以CSV格式存储,可以使用第三方库(如pandas)来加载CSV文件,然后将其转换为RDD或DataFrame。

import pandas as pd

from pyspark.sql import SparkSession

# 创建S服务器托管网parkSession

spark = SparkSession.builder.appName("DataLoadingExample").getOrCreate()

# 使用pandas加载CSV文件

csv_data = pd.read_csv("data.csv")

# 将pandas DataFrame转换为Spark DataFrame

spark_df = spark.createDataFrame(csv_data)

# 显示数据

spark_df.show()

3 从数据库加载数据

Spark支持从关系型数据库中加载数据,可以使用JDBC连接来加载数据。首先,需要提供数据库连接信息,并使用read方法加载数据。

# 配置数据库连接信息

jdbc_url = "jdbc:mysql://localhost:3306/mydb"

connection_properties = {

"user": "username",

"password": "password",

"driver": "com.mysql.jdbc.Driver"

}

# 从数据库加载数据

db_data = spark.read.jdbc(url=jdbc_url, table="mytable", properties=connection_properties)

# 显示数据

db_data.show()

4 从Hive表加载数据

如果在Hive中存储了数据,可以直接在Spark中加载Hive表的数据。

# 从Hive表加载数据

hive_data = spark.sql("SELECT * FROM my_table")

# 显示数据

hive_data.show()

数据保存

在对数据进行处理和分析后,通常需要将结果保存回不同的数据源或文件中。Spark支持多种数据保存方式,以下是一些常见的数据保存方式以及示例代码:

1 保存数据到文本文件

将数据保存到文本文件是一种常见的方式,可以使用saveAsTextFile方法将RDD的内容保存为文本文件。

# 保存数据到文本文件

text_data.saveAsTextFile("output.txt")

2 保存数据到CSV文件

如果希望将数据保存为CSV格式,可以使用DataFrame的toPandas方法将数据转换为pandas DataFrame,然后再保存为CSV文件。

# 转换为pandas DataFrame

pandas_df = spark_df.toPandas()

# 保存为CSV文件

pandas_df.to_csv("output.csv", index=False)

3 保存数据到数据库

将数据保存到数据库也是一种常见的操作,可以使用write方法将数据写入数据库。

# 配置数据库连接信息

jdbc_url = "jdbc:mysql://localhost:3306/mydb"

connection_properties = {

"user": "username",

"password": "password",

"driver": "com.mysql.jdbc.Driver"

}

# 保存数据到数据库

db_data.write.jdbc(url=jdbc_url, table="mytable", mode="overwrite", properties=connection_properties)

4 保存数据到Parquet文件

Parquet是一种列式存储格式,适合于大规模数据的存储和分析。您可以使用Parquet格式来保存数据。

# 保存数据到Parquet文件

spark_df.write.parquet("output.parquet")

性能优化和注意事项

在加载和保存数据时,性能优化是一个重要的考虑因素。以下是一些性能优化和注意事项:

1 数据分区

在保存数据时,合理分区数据可以提高写入性能。您可以使用repartition方法来重新分区数据。

# 重新分区数据

data.repartition(4).write.parquet("output.parquet")

2 数据压缩

在保存数据时,考虑使用数据压缩可以减少存储空间和网络传输开销。可以在保存数据时指定压缩算法。

# 使用Snappy压缩算法保存数据

spark_df.write.parquet("output.parquet", compression="snappy")

3 数据合并

如果需要追加数据到已有的文件中,可以使用mode参数设置为append。

# 追加数据到已有文件中

data.write.mode("append").parquet("existing_data.parquet")

总结

Spark中的数据加载与保存是数据处理流程的重要步骤。本文深入探讨了数据加载与保存的基本概念、常见操作以及性能优化和注意事项。

希望本文能够帮助大家更好地理解和使用Spark中的数据加载与保存功能,并在数据处理和分析任务中取得更好的性能和效果。

服务器托管,北京服务器托管,服务器租用 http://www.fwqtg.net

相关推荐: 50从零开始用Rust编写nginx,原来TLS证书还可以这么申请

wmproxy wmproxy已用Rust实现http/https代理, socks5代理, 反向代理, 负载均衡, 静态文件服务器,websocket代理,四层TCP/UDP转发,内网穿透等,会将实现过程分享出来,感兴趣的可以一起造个轮子 项目地址 国内: …